新报告称人工智能无法保护人们免受Deepfakes技术的影响

来自Data & Society的一份新报告引发了人们对视频欺骗性改变的自动化解决方案的疑虑,包括机器学习改变的视频deepfakes等。作者Britt Paris和Joan Donovan 认为,虽然deepfakes是新的,但却是媒体操纵历史悠久的一部分 - 需要社会和技术修复。依靠人工智能实际上可以通过将更多数据和权力集中在私营公司手中来使事情变得更糟。

Paris表示,“围绕deepfakes的恐慌证明了快速的技术解决方案无法解决结构性不平等问题。这是一个庞大的项目,但我们需要找到同时涵盖社会及政治方面的解决方案,所以没有权力的人不会被排除在外。”

正如Paris和Donovan所看到的那样,只有技术本身将不能解决deepfakes问题。报告中写道:“媒体与真相之间的关系从未如此稳定。” 在19世纪50年代,当法官开始在法庭上允许摄影证据时,人们不相信新技术,并且首选见证证词和书面记录。到了20世纪90年代,媒体公司通过选择性地编辑晚间节目中的图像来参与歪曲事件。“这些图像是真实的图像,”报告说。“操纵的是他们如何在有线电视上全天候进行情境化、解释和广播。”

今天,通过允许人们使用机器学习操纵视频和图像,deepfakes甚至进一步操纵,其结果几乎不可能用人眼检测到。现在,该报告称,“这任何拥有公共社交媒体资料的人都是公平的游戏。”一旦虚假视频存在,它们就可以在几秒钟内在社交媒体上大规模传播。

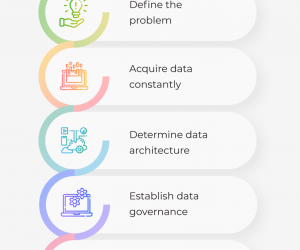

为了解决这个问题,Facebook最近宣布它正在发布一个数据集,允许人们测试旨在检测利用deepfakes视频的新模型。像TruePic这样使用AI和区块链技术来检测被操纵照片的初创公司也开始获得动力。最近,美国国防部高级研究计划局(DARPA)投资了Medifor,后者研究视频像素的差异,以确定什么时候被篡改。但是,几乎所有这些解决方案的目标都是在捕获点(即拍摄照片或视频时)或在检测级别(以便更容易区分篡改和未篡改的内容)之间进行操纵。

法律专家认为这种方法是积极的,并指出,只有通过法院才能解决deepfakes问题。电子前沿基金会公民自由主任 David Greene说道,伪造的视频在政治评论和匿名化需要身份保护的人群中也有重要用途。

“如果要制定一项deepfakes法律,则需要考虑言论自由,”他补充道,如果人们使用deepfakes进行违法行为 - 例如勒索某人 - 他们可能会根据现行法律受到起诉。

但Paris担心人工智能驱动的内容过滤器和其他技术修复可能会造成真正的伤害。她说道:“他们为某些人做得更好,但可能会让其他人变得更糟。设计新的技术模型为公司创造了可以捕获各种图像并创建在线生活库的空间。”

《Deep Fakes: 对隐私,民主和国家安全的迫在眉睫的挑战》论文的合著者Bobby Chesney却并未将数据收集视为一个问题。“我认为,如果不加管制,私人实体将获得更多信息,”他说道。“但这种本来就很糟糕的想法让我觉得没有说服力。”

Chesney和Paris 同意需要某种技术修复,并且它必须与法律系统一起起诉不良行为者并阻止伪造视频的传播。“我们需要谈论缓解和限制伤害,而不是解决这个问题,”Chesney补充道。“Deepfakes将不会消失。”

更多信息来自:东方联盟网 vm888.com

- 02-23人工智能和python之间有什么联系?为何用python?

- 03-022021年值得关注的人工智能趋势

- 03-02人工智能和物联网——5个新兴的应用案例

- 03-02人工智能将使纺织工业的生产过程实现数字化和自动化

- 03-02如何应对人工智能在医疗保健领域的挑战

- 07-21人工智能、物联网和大数据如何拯救蜜蜂

- 01-11全球最受赞誉公司揭晓:苹果连续九年第一

- 12-09罗伯特·莫里斯:让黑客真正变黑

- 12-09谁闯入了中国网络?揭秘美国绝密黑客小组TA

- 12-09警示:iOS6 惊现“闪退”BUG

- 04-21中国产品数字护照体系加速建设

- 04-21上海口岸汽车出口突破50万辆

- 04-21外媒:微软囤货GPU以发展AI

- 04-21苹果手表MicroLED项目停滞持续波及供应链

- 04-21三部门:到2024年末IPv6活跃用户数达到8亿

粤公网安备 44060402001498号

粤公网安备 44060402001498号