重建隐私保障,需要让AI模型快速“忘记你”

隐私,在这个时代早已是伪命题。

为了在一定程度上重建隐私保障,近期一系列立法举措(包括欧洲的〈通用数据保护条例〉以及美国的〈加利福尼亚州消费者隐私法〉)对于清除个人信息做出了相关规定。但是,要想让经过训练的AI模型“忘记你”,传统的方法,只能是从零开始利用新数据进行重新训练——整个过程可能耗时数周,且成本相当高昂。

最近新发表的两篇论文,带来了高效从AI模型中删除记录的方法,有望节约巨量能源并真正为合规性带来保障,一篇来自斯坦福大学,另一篇(预印本)来自多伦多大学。斯坦福大学计算机科学家、第一篇论文的联合作者Melody Guan表示,“我们似乎需要一些新的算法,来简化企业之间的实际合作,确保实现难度不会成为他们违反隐私规定的借口。”

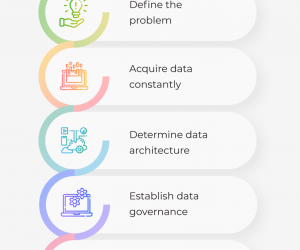

由于关于高效数据删除的文献非常有限,因此斯坦福大学的作者们首先对问题做出明确定义,并提出有助于缓解问题的四项设计原则:

-

第一项原则为“线性度”:简单的AI模型只需要对数字进行加法与乘法运算,这就避免了所谓非线性数学函数的介入,保证步骤分解更加简单易行;

-

第二项则是“惰性”原则,尽可能推迟计算操作,除非确实需要做出预测;

-

第三项为“模块化”:如果可能,尽量以可拆分的形式进行模型训练,而后组合结果;

-

第四项是“量化”,即只要平均值能够锁定在特定的离散区间之内,则删除其中对于平均值结果影响不大的数值。

斯坦福大学的研究人员们将其中两项原则应用到一种名为k均值聚类的机器学习算法当中。此算法用于将数据点分类为自然聚类,例如用于分析密切相关的种群之间的遗传性差异。(在UK Biobank医学数据库中,该聚类算法已经得到实际应用。而且有部分患者已经向数据库作者提出通告,要求将自己的记录从数据库中删除。)研究人员利用量化技术开发出一种Qk均值算法,并立足六套数据集进行了测试,分别对单元格类型、手写数字、手势、森林覆盖率以及联网设备黑客入侵情况进行分类。他们在每组数据集内各删除1000个数据点,每次1个。结果证明,Q-k均值算法的速度达到常规k均值算法的2倍到584倍,且准确性几乎没有任何损失。

利用模块化方法,他们又开发出DC-k均值(用于实现分治法)。数据中的各个点被随机划分为多个子集,且各个子集将独立进行聚类。接下来,再将这些子集构成新的集群,依此类推。事实证明,从单一子集内删除一个点,并不会影响到其他子集的结果。新算法的加速水平在16倍到71倍之间,且准确性同样几乎不受影响。该项研究被发表在上个月的加拿大温哥华神经信息处理系统(NerulPS)大会上。

多伦多大学以及Vector研究院计算机科学家Nicolas Papernot指出,“这篇论文中的亮点,在于利用算法中的某些基本面(k均值聚类)完成了以往无法实现的目标。”但是,其中某些方法在其他算法类型中无法确切起效,例如在深度学习中使用的人工神经网络。上个月,Paernot以及其他联合作者在网站arXiv上发表一篇论文,提到一种适用于神经网络的训练方法,名为SISA(分片、隔离、切片以及聚合)训练。

这种新方法采取两种不同的模块化实现方式。首先,在分片部分中将数据集划分成多个子集,并立足每套模型建立独立的训练模型副本。当需要进行预测时,各模型的预测结果将被汇总为统一的整体。利用这种方式,删除数据点时,我们只需要重新训练其中一套模型。第二种方法则是切片,即对各个子集做出进一步细分。该子集的模型会首先在切片1上训练,而后同时在切片1与切片2上训练,接下来在切片1、切片2以及切片3上训练,依此类推。最后,在完成各个步骤后对训练完成的模型进行归档。如此一来,如果删除切片3中的数据点,则可快速返回至训练的第三步中,并以此为起点继续训练。Papernot表示,分片与切片方法“相当于为我们的模型训练流程提供了两个调整旋钮。”Guan也称赞称,这种方法“非常直观”,只是“使用的记录删除标准还不够严格。”

来自多伦多的研究人员们通过两套大型数据集训练神经网络,希望测试这种方法。其中一套数据集包含超过60万张与家庭住址编码相关的图像,另一套则包含30多万条购买历史记录。他们从各个数据集中删除0.001%的数据量,而后重新训练,并发现分片技术(20个分片)使得地址相关任务的重新训练速度提高 了3.75倍,购买记录相关任务的重新训练速度提高 8.31倍(与标准模型重新训练方法比较),而且几乎不会对准确度造成影响。在配合切片方法之后,地址相关任务的速度进一步提高 了18%,购买记录相关任务的速度提高 43%,准确度同样没有降低。

公开发布的数据显示,仅删除0.001%的数据似乎太过温和,但Papernot表示谷歌搜索等服务的重新训练规模要比这个数字还低出几个量级。另外,18%的速度提升看似有限,但对于大型机使用场景来讲,已经能够节约海量时间与金钱。另外,在某些情况下,我们也许能够发现某些更有必要忽略的数据点——例如来自少数族裔或者患有特定疾病的人群,确保他们免受隐私侵犯的影响。将这些数据点集中起来,将进一步提高删除效果。Papernot表示,他们也在积极整理数据集知识,希望进一步提高SISA方法的定制化水平。

Guan解释道,某些AI方法虽然在设计上就考虑到隐私性要求,但有时候使用者仍然需要删除其中的某些特定数据点。举例来说,有些人可能不想把自己的数据交给某家声名狼藉的企业,科学家们有时候也可能需要删除引发问题的数据点(例如黑客用来「毒化」数据集的伪造记录)。无论是哪一种情况,对AI模型中的数据进行删除都将成为一种必要的手段。

Guan总结道,“很明显,我们还没有构建起完整的解决方案。但我们认为对问题做出明确定义,是解决问题的重要前提。希望人们能够在算法设计之初,就充分考虑到数据保护方面的需求。”

更多信息来自:东方联盟网 vm888.com

- 02-23人工智能和python之间有什么联系?为何用python?

- 03-022021年值得关注的人工智能趋势

- 03-02人工智能和物联网——5个新兴的应用案例

- 03-02人工智能将使纺织工业的生产过程实现数字化和自动化

- 03-02如何应对人工智能在医疗保健领域的挑战

- 07-21人工智能、物联网和大数据如何拯救蜜蜂

- 01-11全球最受赞誉公司揭晓:苹果连续九年第一

- 12-09罗伯特·莫里斯:让黑客真正变黑

- 12-09谁闯入了中国网络?揭秘美国绝密黑客小组TA

- 12-09警示:iOS6 惊现“闪退”BUG

- 04-29通用智能人“通通”亮相中关村论坛

- 04-29拼多多投入45亿补贴,助力上海“五五购物节

- 04-29通义千问再开源 推出最大尺寸1100亿参数模型

- 04-29【环球视线】比亚迪交付首列出海云轨

- 04-21中国产品数字护照体系加速建设

粤公网安备 44060402001498号

粤公网安备 44060402001498号